Когда вы впервые услышали термин «robots.txt», вероятно, вы не имели ни малейшего представления о том, что он собой представляет и для чего нужен. У вас возник вопрос: «какое отношение он имеет к СЕО?». И это понятно, не каждый сможет сразу понять, что представляет собой техническое СЕО. Однако, оно играет важную роль, что подтверждается результатами исследований, проведенных seoClarity и BuzzStream: 59% из 240 опрошенных специалистов выразили мнение, что техническая оптимизация «на сайте» является наиболее эффективной стратегией SEO. Техническое SEO по-прежнему играет важную роль в маркетинговых стратегиях.

Ниже рассмотрим сам файл, а также принципы его использования в рамках вашей стратегии SEO-продвижения. Мы также расскажем о том, как его создавать, редактировать и добавлять на сайт.

Robots.txt – общая информация о файле

Файл robots.txt используется поисковыми системами (ПС), которые (с учетом содержащихся в нем данных), выбирают определенный вариант сканирования/индексирования содержимого страниц вашего веб-сайта. Он помогает поисковым роботам сканировать ваш ресурс и правильно индексировать имеющийся на нем контент, чтобы пользователи смогли найти искомую информацию по соответствующим запросам. С помощью специальных инструкций, записанных в файле, можно включать/отключать индексацию страниц. Поисковая система в первую очередь ищет robots.txt, считывает имеющиеся в нем данные (команды) и только после этого инициируют процесс сканирования сайта.

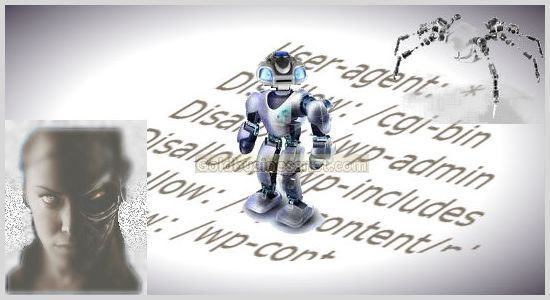

Robots.txt использует особый язык. Рассмотрим несколько ключевых терминов:

- User-agent – поисковая система;

- Disallow – запрет на сканирование страниц по указанным URL;

- Allow – разрешение доступа к указанным веб-страницам.

Возможности файла:

- установка запрета доступа к некоторым страницам сайта;

- отключение индексации поисковыми роботами определенных файлов;

- разрешение на сканирование указанных страниц;

- установка запрета на сканирование некоторых страниц для поисковых систем.

Зачем скрывать некоторые страницы веб-сайта от поисковых систем и запрещать последним сканировать веб-сайт? Это нужно, чтобы поисковая система работала только с актуальным свежим контентом, игнорировала устаревшие, одинаковые или закрытые страницы. Ниже рассмотрены лучшие варианты применения файла robots.txt.

1. Запрет доступа к некоторым страницам

Есть ли внутренние страницы на вашем сайте? Пользователи посещают ваш сайт и получают доступ к закрытым данным. Например, у вас есть сотрудники, использующие ваш сайт для просмотра страницы с персоналом вашей компании. В любом случае, эти страницы не должны быть общедоступными (то есть, не отображались в поисковой выдаче). Используя robots.txt, вы можете запретить ПС сканировать определенные страницы.

Второй случай – процесс разработки сайта. Вероятно, вы не хотите, чтобы страницы тестового сайта сканировали и индексировали поисковые роботы. Их должен видеть только заказчик. Поэтому, следует установить запрет на индексацию.

2. Удаление страниц из списка индексируемых

На вашем сайте могут быть различные файлы, доступные для скачивания пользователями, например pdf. Также у вас может быть дублируемый контент, используемый повторно в маркетинговых целях. Эти файлы не должны индексироваться поисковыми системами. Установите запрет на сканирование страниц и файлов с помощью robots.txt.

3. Открытие доступа на сканирование любых страниц сайта

Если вы хотите сделать каждую страницу веб-сайта доступной для сканирования поисковыми роботами, robots.txt поможет ускорить этот процесс. Просто создайте файл с соответствующим названием и запишите необходимые инструкции, открывающие доступ к сканированию.

4. Запрет на сканирование определенных страниц

Некоторые страницы веб-сайта не должны быть среди тех, которые сканируют поисковые системы. Например, обучающая программа HubSpot предполагает, что новые сотрудники смогут создать веб-сайт с помощью инструментов HubSpot. Но эти сайты создают в рамках определенного проекта, поэтому их страницы не должны индексироваться поисковыми системами. Поэтому они создают файл robots.txt с инструкцией, запрещающей индексирование.

С помощью файла можно выбрать одну или несколько ПС, которым будет закрыт доступ к выбранным страницам. Например, указав «Google» напротив тега User-agent, вы запретите доступ поисковым роботам этой ПС к вашему контенту.

В этом случае robots.txt лишь укажет поисковым системам, что им не следует сканировать определенные страницы, но не гарантирует того, что они не станут это делать. Чтобы предотвратить индексирование, рекомендуют использовать две директивы: noindex и nofollow.

Зачем нужен файл robots.txt, если он неспособен предотвратить индексирование страниц? Суть в том, что он ускоряет процесс сканирования страниц поисковыми роботами, а также позволяет устанавливать приоритет. Технически, он удаляет страницы из поисковых систем.

Создание и добавление файла на сайт

Создать robots.txt не составит большого труда. Понадобится любой текстовый редактор (даже стандартные программы, встроенные в Windows, MacOS и прочих ОС)). Все строки, которые должен содержать этот файл, можно найти в Google. Примерное содержимое файла:

User-agent: *

Allow: /

Вы можете заполнить поле после User-agent (звездочка по умолчанию означает, что доступ открыт для всех поисковых систем). Далее можно указать Allow или Disallow, перечислив напротив требуемые страницы. Google предлагает специальный инструмент, с помощью которого вы можете протестировать файл, прежде чем добавите его на свой сайт.

Создав и отредактировав файл, вы можете загрузить его на сайт через Cpanel (меню «Add File»). Имейте ввиду, что не все поисковые системы поддерживают файл robots.txt.

Как найти файл robots.txt на сайте

Найти файл robots.txt легко: укажите свое доменное имя (основной URL сайта), в конце укажите «/robots.txt», после чего в окне отобразится его содержимое. В противном случае у вас отсутствуют какие-либо настройки, связанные с использованием этого файла, или файл не был создан ранее.

Файлы robots.txt находятся в открытом доступе. Вы можете ввести любой URL, добавив «/robots.txt» в конце строки, и просматривать файл этого сайта (если он имеется). Кроме того, в нем содержатся адреса расположения любых файлов sitemap, связанных с конкретным доменом.

Как редактировать файл roots.txt

Вы можете внести новые настройки, отредактировав файл в любой момент. Для этого нужно найти файл на сайте, удалить имеющиеся в нем строки, вставить новый текст, заранее написанный в любом текстовом редакторе. Выполните три простых действия, описанные ниже.

1. Поиск файла robots.txt в вашей CMS (системе управления контентом сайта)

Процесс поиска может отличаться в зависимости от типа CMS, используемой вашим сайтом (например, Wordpress и HubSpot). Зайдите в панель администратора сайта, выберите пункт «Настройки» и вкладку «СЕО». Там вы найдете файл robots.txt.

Если ваш сайт не создан на основе CMS, воспользуйтесь учетной записью вашего хостинга. Перейдите в раздел «Управление файлами» и найдите искомый файл вручную. Он будет доступен для чтения и редактирования.

2. Удаление содержимого файла

Если вам удалось открыть файл, вы можете удалить всю текстовую информацию, содержащуюся в нем. Это все, что вам нужно сделать на данном этапе.

3. Вставьте текст из редактора

Скопируйте текст, написанный ранее в текстовом редакторе, и вставьте его в файл robots.txt. Не забудьте нажать «Сохранить», чтобы изменения вступили в силу.

Файлы, относящиеся к техническому СЕО (включая robots.txt), могут казаться сложными на первый взгляд. Но вы можете легко их редактировать, помогая поисковым системам быстрее сканировать ваш сайт. В конечном итоге, это позволит улучшить ваши позиции в поисковой выдаче.